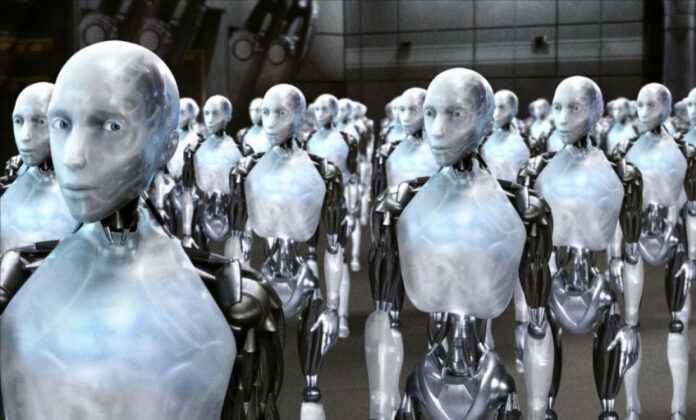

Come fare in modo che una I.A. (che sia un automa o meno) risponda ai comandi degli esseri umani e non faccia loro del male? Ci aveva pensato già Isaac Asimov, più di 80 anni fa

Non è un caso se Isaac Asimov è considerato il padre della robotica, almeno per ciò che concerne la narrativa: lo scrittore americano si occupava infatti di robot e automi intelligenti (quindi, di fatto, di I.A. con corpi meccanici e semi-umani) ben prima che l’argomento diventasse anche solo rilevante.

Le storie fantascientifiche dello scrittore, che in vari cicli di romanzi esplorano una vera e propria storia futura dell’umanità per lo spazio di centinaia di migliaia di anni, pongono molto l’accento su come le I.A. e i robot, creature a cui era affezionatissimo, saranno importanti per l’evoluzione della nostra specie e della nostra civiltà.

E, alla base della sua indagine, ci sono le tre celeberrime leggi della robotica, ossia tre assiomi che dovrebbero decidere del perfetto funzionamento di ogni automa. Tre leggi colme di lacune, in realtà, come esplorato ampiamente dall’autore nelle storie brevi delle sue raccolte come Io, Robot (1950).

Le tre leggi compaiono per la prima volta nella storia Runaround, del 1942, pubblicata in origine sulla rivista Astounding Science Fiction. I protagonisti sono due personaggi ricorrenti nella narrativa breve di Asimov: Gregory Powell e Mike Donovan. Costoro, incaricati di testare il funzionamento dei robot in situazioni limite, si ritrovano spesso nei pasticci proprio per via delle tre leggi.

Le tre leggi seguono una scala gerarchica, nel senso che la prima è più importante della seconda e la seconda è più importante della terza. Per fare un esempio: se un robot fosse costretto a danneggiarsi o anche a sacrificarsi per salvare un essere umano in pericolo di vita, potrebbe farlo perché la prima legge ha precedenza sulla terza. Eccole enunciate:

- Un robot non può arrecare danno a un essere umano, o permettere che a causa del suo mancato intervento un essere umano subisca danno;

- Un robot deve obbedire agli ordini di un essere umano, a meno che questo non contrasti con la prima legge;

- Un robot deve proteggere la propria esistenza, a meno che questo non contrasti con la prima o la seconda legge;

Altro esempio: se qualcuno ordinasse a un robot di uccidere un essere umano esso non ne sarebbe in grado, perché la prima legge ha precedenza sulla seconda; o ancora: se qualcuno ordina a un robot di suicidarsi, danneggiarsi o spegnersi, potrebbe farlo perché la seconda legge ha la precedenza sulla terza.

Gran parte dei racconti di Asimov in questa prima fase della sua opera sono dedicati ai contrasti tra le tre leggi e al tipo di confusione interpretativa che ne può sorgere. Questo accade anche in Runaround, storia nella quale un robot si ritrova indeciso se obbedire alla seconda o alla terza legge e rimane bloccato in un loop, girando continuamente in circolo.

La storia è ambientata su Mercurio nel 2015 (ricordiamo che è del 1942): Powell e Donovan devono testare il robot Speedy, e lo mandano a recuperare del selenio per il supporto vitale della loro base sulla superficie (per loro) inospitale del pianeta. Ma il selenio cela un pericolo, e l’automa non sa se obbedire agli ordini (seconda legge) o mettere a rischio la propria vita (terza legge). Sicché, si blocca.

Solo la chiamata in causa della prima legge, scatenata da Powell che si mette in pericolo a sua volta uscendo sulla superficie, fa in modo di sbloccarlo e salvare la situazione. Questi esempi di conflittualità sono spesso rappresentati da Asimov in situazioni critiche da thriller sci-fi colme di tensione, in cui gli stessi Powell e Donovan o anche altri esseri umani rischiano di morire.

Non è finita: volendo complicare ulteriormente le cose ci sarebbe anche una legge zero, sviluppata nel corso dei romanzi proprio da due robot e, in maniere contorte e occulte, posta da essi stessi come “guida” dell’intero destino dell’umanità: “Un robot non può danneggiare l’umanità, o permettere che l’umanità subisca danni a causa del suo mancato intervento”.

Questo comporta che anche la legge uno diverrebbe meno importante e sarebbe perciò possibile, per i robot, effettivamente fare del male ai singoli esseri umani o persino ucciderli, purché ciò giovi all’umanità intera. Casi inerenti vengono esplorati da Asimov nelle sue ultime opere, nei romanzi del Ciclo dei Robot e negli ultimi lavori del Ciclo della Fondazione.

Che applicazioni potrebbero trovare queste leggi con le moderne I.A.? Non lo sappiamo, ma di certo Asimov ha fatto un buon riassunto di quali sarebbero i punti chiave sui quali soffermarsi nello sviluppo delle stesse. Quanto Elon Musk e i suoi colleghi intendano seguirli per evitare anche scenari potenzialmente apocalittici, è tutto da vedere.

Continuate a seguirci su LaScimmiaPensa

![Hayao Miyazaki contro l’arte generata da I.A.: “Sono completamente disgustato” [VIDEO] Miyazaki](https://www.lascimmiapensa.com/wp-content/uploads/2025/03/image-303-218x150.png)

![I Meme più famosi rifatti dalla I.A. in stile Studio Ghibli sono uno spettacolo [FOTO] Meme](https://www.lascimmiapensa.com/wp-content/uploads/2025/03/image-291-218x150.png)

![Elon Musk: Grok 3 ha una modalità “por*o” e gli utenti stanno impazzendo [FOTO] Grok](https://www.lascimmiapensa.com/wp-content/uploads/2025/02/image-269-218x150.png)

![Cina: robot I.A. va fuori controllo e tenta di aggredire la folla, il video è virale [VIDEO] robot](https://www.lascimmiapensa.com/wp-content/uploads/2025/02/image-264-218x150.png)

![Donna ingannata da un Brad Pitt I.A.: l’inganno le porta via 830mila dollari [FOTO] Brad](https://www.lascimmiapensa.com/wp-content/uploads/2025/01/image-118-218x150.png)